AX研究室の庄内です。AX研究室ではLLM・AIエージェントなどを含むAI・DX案件だけではなく、これまでデータアナリティクス部で取り組んでいた需要予測・異常予兆検知などを含む様々なAI開発も引き続き取り組んでいます。マイナーな分野ですが、地球環境分野へAIを適用するプロジェクトに結構携わっているので、これらの分野においても日々様々な技術動向を調査しています。

先日、「周回遅れのAI気象予測」という記事が日本経済新聞(2025年6月22日)に掲載され、欧米や中国に比べて日本のAI気象予測開発が遅れている現状に警鐘を鳴らしつつ、その利点を見極めた上での積極的な開発を促すよう指摘されました。政府の会議でもAI活用の方針が示されるなど、この分野が日本でも重要な社会的・技術的課題として認識され始めたことがうかがえます。

ここでしばしば誤解されがちなのが、従来のシミュレーションとAIモデルの根本的な違いです。ごく簡単に言うと、以下のようになります。

- 物理モデル(シミュレーション):気圧や気温といった要素が物理法則に従ってどう変化するかを、スーパーコンピューターで逐次計算するアプローチです。気象庁がこれまで重視してきた手法です。

- AIモデル:膨大な過去の観測データから、気象現象のパターンや変数間の複雑な関係性をAI自身が獲得し、未来を予測するアプローチです。

物理モデルが方程式を解く「演繹的」なアプローチだとすれば、AIモデルはデータから法則を見出す「帰納的」なアプローチと言えるでしょう。記事でも指摘されている通り、AIはその計算過程が「ブラックボックス」になりがちで、予測根拠の説明が難しいという課題がありました。しかし、その驚異的な予測スピードと低コスト化の可能性、そして人間が気づかなかった新たな知見をもたらす潜在能力から、今や世界の気象予測の潮流は大きく変わりつつあります。

私たちも、2023年に『Science』誌で発表されたGoogle DeepMindの気象予測AI「GraphCast」をオンプレミスCPU環境で動作させる検証を行いました。何千万円もするGPU環境がなくても、デモのノートブックは完走できました。

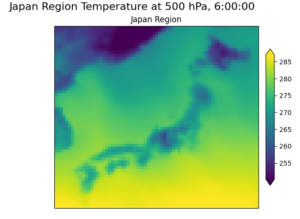

-2025-05-22-231719-300x143.png) しかし、0.25度メッシュの解像度では、日本付近を拡大すると粗いモザイク状になるので直接的な利用というよりは、詳細シミュレーションの境界条件などとして間接的に利用すると、AI化による計算高速性が活きてくると思われます。

しかし、0.25度メッシュの解像度では、日本付近を拡大すると粗いモザイク状になるので直接的な利用というよりは、詳細シミュレーションの境界条件などとして間接的に利用すると、AI化による計算高速性が活きてくると思われます。

そんな中、2025年5月に『Nature』誌にMicrosoftが開発した「Aurora」の論文が掲載されました。論文を読み解くうちに Aurora は単なる高精度な予測ツールではなく、これからの地球科学を激変させる大きなパラダイムシフトの始まりを予感させるモノだと確信しました。

これは、今をときめくLLMが単なるチャット・アプリケーションではなく、質疑応答文や穴埋め問題などのデータから言語文法や概念などを学び様々なアプリケーションの基盤として欠かせないものになったように、地球全体の物理現象をAIが自律的に学習する 地球科学のための新たな基盤モデル を意図されているからにほかなりません。

本稿では、Auroraが従来の気象予測とどう違うのか、そしてその背後にあるMicrosoftのプラットフォーム戦略について、論文をもとに考察していきます。

Auroraの核心:単なる予測ツールではなく「地球科学のための基盤モデル」へ

Auroraの最も注目すべき点は、その目標が特定のタスク(例:高精度な天気予報)に特化したツール開発ではない、という点です。Auroraが目指すのは 「基盤モデル(Foundation Model)」 としてのプラットフォーム構築です。

これは、まず巨大な単一モデルに、大気現象に関する汎用的かつ基礎的な知識、いわば「大気の物理的常識」を学習させ、その堅牢な土台の上で多様な応用タスクを展開していくというアプローチです。

汎用的な知能を構築し、それを様々な個別問題の解決に適用する、という思想は、まさに大規模言語モデル(LLM)が辿った成功への道筋を、地球科学の領域で再現しようとする試みと言えるでしょう。

Auroraの学習戦略:LLMと同様の「事前学習ーファインチューニング」

では、どのようにして「大気の常識」を獲得するのでしょうか。Auroraの学習プロセスは、LLMで一般的となった2段階のアプローチを採用しています。

- 事前学習(Pre-training)

13億パラメータを持つ巨大な単一モデルに対し、100万時間分を超える膨大な過去の気象・気候データを投入します。このプロセスを通じて、モデルは大気の物理法則や典型的な変動パターンなど、根本的な原理を広範に学習します。これは、LLMがインターネット上の膨大なテキストデータから言語の文法や世界の知識を自己教師あり学習するプロセスと酷似しています。 -

ファインチューニング(Fine-tuning)

汎用的な知識を獲得した基盤モデルを、次に応用タスクに合わせて微調整します。例えば、「特定地域の高解像度短期予報」や「大気汚染物質の濃度予測」といった具体的な課題です。この段階では、事前学習時よりもはるかに小規模で、タスクに特化した高品質なデータセットが用いられます。

この戦略の利点は、一度計算コストをかけて高性能な基盤モデルを構築すれば、その後の多様な応用モデルの開発が、比較的低いコストと短い期間で実現可能になる点です。これこそが、Microsoftが描くプラットフォーム戦略の核心部分です。

これは、個別の予報タスクごとに専門モデルをスクラッチから開発・調整してきた従来の数値気象予報(NWP: Numerical Weather Prediction)とは、開発思想が根本的に異なります。

Auroraの柔軟性を支えるアーキテクチャ

プラットフォームとしての柔軟性と汎用性を実現するため、Auroraはいくつかの重要な技術的要素を取り入れています。

- 3D Perceiver エンコーダ/デコーダ

PerceiverIOフレームワークを利用したアーキテクチャで、衛星画像、地上センサー値など、形式の異なる多様な入力データを統一的なフォーマットで処理するための、いわば「万能な入力アダプター」として機能します。これにより、モデルは様々なデータソースを区別なく扱え、高い汎用性を獲得しました。 -

3D Swin Transformer

大気の複雑な3次元構造(高度方向の差異や、異なる高度間での相互作用)を効率的に捉えるために採用されています。この3次元的な特徴抽出能力が、多様なデータから大気の全体像を学習するための技術的な屋台骨となっています。

高い汎化性能:大気汚染予測で示された「根本原理」の理解

Auroraのポテンシャルを示す興味深い結果として、大気汚染(特定の化学物質の濃度予測)タスクでの高い精度が報告されています。これは、風の動きとは異なる物理現象であり、通常は専門の移流拡散モデルが必要とされる領域です。

この結果は、Auroraが単なる入力データと出力の相関パターンを記憶しているだけでなく、大気の流れという、より根本的な物理原理を理解し始めている可能性を示唆しています。つまり、汚染物質の挙動を直接学習していなくても、一度獲得した大気力学に関する汎用的な知見を応用し、未知のタスクにも対応できる高い汎化性能を持つということです。

Microsoftが描くビジョン:地球システム全体のデジタルツインへ

Microsoftの構想は、大気圏に留まりません。

論文では、この基盤モデルのアプローチを海洋、陸地、氷床など、地球システムの他の構成要素へも拡張し、最終的には 地球全体を統合的にシミュレーションする統一された地球システムモデル の構築を示唆しています。AIが地球を相互作用する一つのシステムとして理解し、予測する。これは「デジタルツインアース」構想の実現に向けた大きな一歩と言えるでしょう。

この動きは、科学研究のあり方そのものにも影響を与える可能性があります。高性能な基盤モデルがAPIなどを通じて広く利用可能になれば、各研究機関がモデル開発に費やしてきた多大な労力と計算コストが大幅に削減されます。

結果として、研究者は気候変動の影響評価や、より局所的で高精度な防災情報の生成といった、具体的な課題解決や応用研究にリソースを集中できるようになります。これは、研究開発における一種の 「民主化」 を促進するかもしれません。

まとめ:AIが拓く、データ駆動科学の新しい地平

従来型の科学アプローチは、個別の現象を支配する方程式を精密にモデル化することに注力してきた。これに対し、Auroraの登場は、AIが膨大なデータの中からシステム全体を貫く基本原理を自ら獲得し、それを多様な問題に応用していく という、新しい科学のパラダイムへのシフトを予感させます。

このアプローチが有効であるならば、私たちがまだ完全には解明できていない他の複雑系――例えば、経済システム、社会動態、さらには生命現象の原理といった領域においても、データ駆動でAIが本質的な法則性を発見する、という未来が拓けるかもしれません。それは、これまで人間が見出すことのできなかった新たなパターンや法則の発見に繋がる可能性を秘めているのではないでしょうか。

AIより大切なこと:観測やシミュレーションしか正解データを作れない!

AIモデルが素早く精度よく予測結果を出力できるようになる未来について話してきましたが、現実を知る 観測や法則に基づく現象の シミュレーション(再現) が必要なくなるわけではありません。むしろ、プレイヤーが限られる極めて重要なタスクになっていくと考えられます。

なぜなら、観測データは正解であり、シミュレーションは物理法則の反映(正解に準ずるもの)だからです。ある時代で正解を作り、そのAIモデルを構築しても、さらに精度が必要になった時は、より精度の高い正解を作るために観測やシミュレーションを実施しなければならなくなります。(AIモデルを蒸留したからと言って、劣化高速版しかできません。)

これまで、応用アプリ側にもシミュレーションを組み込まざるを得なかったので、 スパコン開発やシミュレーションにも規模の経済が効いていました が、AIモデルの普及により、応用アプリ側は安価なAIモデルに移行して行き、応用側でのスパコン需要は急激に減少する可能性があります。スパコン開発やシミュレーションのコストは跳ね上がり、二、三か国の一部の国や国際協調でしか調達できない代物になるでしょう。

しかし、いくらお金がかかろうとも、必要な精度の観測機器を開発し、地球上の至る所に設置し、超スーパーコンピュータを開発し続けて、観測結果を反映したシミュレーションを開発することで、AIモデルの材料になる正解データの精度を上げていかなければ、本当の発展はありません。

くれぐれも、超高速高精度AIモデルがあるんだから、もう観測とかスパコンとかいらないんじゃない?とかスパコン≒オワコン的な誤解が広がらないように注視し続けたいものです。